Contenido

PalancaTiempo discreto Cadenas de Markov

Cuando estamos en presencia de un fenómeno aleatorio, notamos que el futuro depende solo del presente. Es en esta condición que se pueden modelar las cadenas de Markov en tiempo discreto.

Deje (Xno) una secuencia de variables aleatorias con valores en un conjunto finito de J estados, Xt= j es el estado del sistema en el tiempo t. Decimos que Xno es una cadena de Markov de transición si qq es n, qq es i0,…, In + 1 :

P (X(n + 1)= yo(n + 1) | Xno = yono,…, X0= yo0) = P (X(n + 1) = yo(n + 1) | Xno = yono)

Se dice que tal proceso no tiene memoria. El valor de esta probabilidad se denota por pn (n + 1).

Notamos que X0 no está fijada por la definición, esta ley se llama ley inicial. El vector de las probabilidades iniciales se denota por π, con πj= P (S0= j) con j incluido en el conjunto finito y la suma de πj=1.

La matriz de probabilidad de transición es la concatenación de los vectores de probabilidad de transición. Por lo tanto, todos los términos son positivos o cero, la suma de los términos en una línea es igual a 1. Las potencias de una matriz de transición (o matriz estocástica) son matrices estocásticas.

Cadenas de Markov de tiempo discreto homogéneas

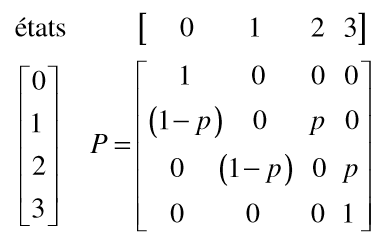

Pongamos un ejemplo. Siempre que un jugador tenga dinero, juega apostando £ 1. Gana £ 1 con una probabilidad de py pierde su apuesta con una probabilidad (1-p) con p entre 0 y 1. El juego termina cuando tiene £ 3.

Podemos definir cuatro estados: 0, 1, 2, 3, que representan el dinero que tiene. La matriz de transición es la siguiente:

Las cadenas de Markov en tiempo discreto pueden tener una ley inicial que se presenta en forma de vector estocástico (la suma es igual a 1). Esta ley representa la distribución en el origen.

Representación de cadenas de Markov en tiempo discreto

Denotemos por Q la matriz de transición. Una secuencia de estados (x1, X2,. . . , Xmetro) define un camino de longitud m que va desde x1 a xmetro en el gráfico asociado con la cadena de Markov homogénea si y solo si Q (x1, X2) Q (x3, X4). . .Q (xm-1, Xmetro)> 0.

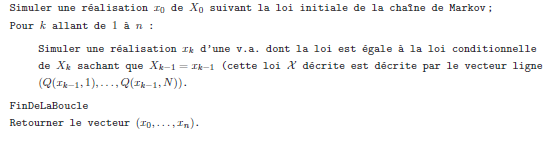

Cuando intentamos simular los primeros estados de cadenas de Markov en tiempo discreto homogéneo (Xno) del espacio de estados finito X = {1 ,. . . , N} descrito solo por su ley inicial y su matriz de transición Q podemos usar el siguiente algoritmo:

La probabilidad de estar en un estado j desde un estado i después de n iteraciones equivale a multiplicar la matriz de transición Qno por el vector inicial. La respuesta es entonces Qno(yo, j).

Gráficos reducidos de cadenas de Markov de tiempo discreto

Un estado j es accesible desde un estado i si existe una probabilidad estrictamente positiva de alcanzar el estado j desde el estado i en un número finito de transiciones. Desde un punto de vista de Teoría de grafos, j es accesible desde un estado i si hay un camino entre i y j.

Un gráfico reducido es una partición de una cadena de Markov en clases de equivalencia, de modo que todos los estados de una clase se comunican entre sí.

Las clases de equivalencia son las siguientes:

- se dice que una clase es transitoria si es posible dejarla, pero en este caso, el proceso nunca podrá volver a ella;

- se dice que una clase es recurrente o persistente si no se puede abandonar. si un clase recurrente se compone de un solo estado, se dice que es absorbente.

Si la partición en clases de equivalencia induce solo una clase recurrente, se dice que la cadena de Markov es irreducible. Una cadena de Markov tiene al menos una clase recurrente.

Ejemplo de cadenas de Markov de tiempo discreto

Estamos interesados en el desarrollo de un bosque natural en una región templada en una parcela. Nuestro modelo tiene 3 estados. El estado 1 es el de vegetación compuesta por pastos u otras especies con bajo balance de carbono; l'état 2 correspond à la présence d'arbustes dont le développement rapide nécessite un ensoleillement maximal et dont le rendement carbone sera maximale, et l'état 3 celui d'arbres plus gros qui peuvent se développer dans un environnement semi ensoleillé (considéré comme un bosque). Si estos tres estados se denotan respectivamente por h, a, f (para hierba, arbustos, bosque), el conjunto de estados posibles para un punto dado de esta gráfica es el conjunto s={h, a, f}. En la parcela, se identifican en el suelo un gran número de puntos distribuidos en una cuadrícula regular y se registra el estado de la vegetación en cada uno de estos puntos a intervalos de tiempo fijos. Este tipo de programa se llama autómata celular.

Al observar la evolución durante un intervalo de tiempo, se puede determinar para cada estado i∈S la proporción de puntos que pasaron al estado j∈S, y anotar pij esta proporción. Si las diferentes proporciones así señaladas (hay 9) cambian poco de un intervalo de tiempo al siguiente, podemos suponer que no cambian con el tiempo y podemos mirar las probabilidades para cualquier punto de pasar del estado i en el estado j para un intervalo de tiempo. Supongamos, por ejemplo, que en este gráfico, estas probabilidades son las siguientes:

Si X0 indicar el estado de un punto en el tiempo t = 0 y X1 el estado del mismo punto en t = 1, por ejemplo, tenemos la probabilidad de pasar del estado de arbusto en t = 0 al estado de bosque en t = 1 se escribe P (X1= f: X0= a) es igual a 0, 4.

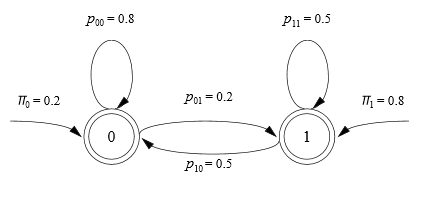

El conjunto de estados S y la matriz de transición P constituyen un ejemplo de cadena de Markov. También podemos representar esta cadena de Markov mediante el siguiente gráfico:

En este modelo, podemos entonces calcular la probabilidad de cualquier sucesión de estados, llamada trayectoria de la cadena de Markov. Por ejemplo, la probabilidad de que en un punto de la gráfica observemos la sucesión de estados (h, h, a, f, f) se calcula de la siguiente manera:

donde π0 es la probabilidad de estar en el estado en el momento inicial t = 0.

Observación del estado en el que se ubican los distintos puntos de la parcela en el tiempo inicial t0 permite determinar las proporciones iniciales de cada uno de los 3 estados. Para eso, se anota para cada punto el estado en el que se encuentra y se calcula la proporción de puntos de cada uno de los estados posibles. Podemos ver cada proporción como la probabilidad de que un punto de la gráfica se encuentre en uno de los estados en el instante inicial. Así, si tenemos por ejemplo π0 = (0.5, 0.25, 0.25), esto significa que la mitad de los puntos de la parcela están inicialmente en el estado h, una cuarta parte en el estado ay una cuarta parte en el estado f. Pero también podemos interpretar esto considerando que cualquier estado tiene una probabilidad 50% de estar en el estado h, 25% de estar en el estado ay 25% de estar en el estado f. Es por esto que la proporción de individuos de la población estudiada ubicados en cada uno de los estados,

se llama ley de probabilidad inicial o distribución inicial. Cuando uno elige un modelado por una cadena de Markov, el objetivo a menudo es determinar la evolución de la distribución de estados a lo largo del tiempo. Por ejemplo, si la parcela considerada arriba está cubierta por un tercio de bosque en el momento inicial, ¿crecerá esta proporción, tenderá a 100%, por el contrario tenderá a cero o se acercará a un valor? Tipo límite de equilibrio ecológico?

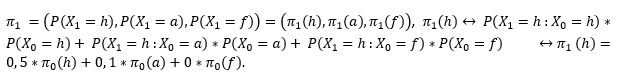

Veremos que si conocemos la distribución inicial podemos calcular la distribución en el tiempo t = 1, luego en el tiempo t = 2 y así sucesivamente. Calculemos para t = 1:

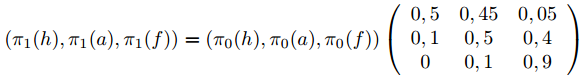

Deducimos que π1(h) es el producto escalar del vector π0 con la primera columna de la matriz P. Del mismo modo, comprobamos que π1(a) es el producto escalar del vector con la segunda columna de la matriz P y que π1(f) es el producto escalar del vector con la tercera columna de la matriz P. Resumimos esto: π1= π0pag.