Contenido

PalancaEjercicios corregidos: cadenas de Markov en tiempo discreto

Esta página incluye muchos ejercicios corregidos sobre cadenas de Markov en tiempo discreto y comportamiento asintótico, clase, cadena ergódico, captación.

Ejercicio 1

construir el cadena de markov correspondiente a la siguiente matriz estocástica:

0.4 | 0.6 | 0 |

0.2 | 0.5 | 0.3 |

0 | 0.4 | 0.6 |

¿Cuánta clase tiene la cadena? ¿Es reducible? Si es así, redúzcalo. Calcule la probabilidad estacionaria, si existe, de la cadena irreducible. Calcula la periodicidad de las clases.

Para representar la cadena, elegimos numerar los estados del 1 al 3, en el orden de las filas de la matriz de transición:

Para verificar las clases en la cadena, necesitamos verificar los estados de comunicación. Aquí, 1 se comunica con 2 y 2 con 3 (por tanto accesible en ambas direcciones), por transitividad 1 se comunica con 3. La cadena tiene una sola clase, es irreductible. Por lo tanto, los estados son todos recurrentes y aperiódicos porque todos tienen un bucle sobre sí mismos. En estas condiciones, la cadena admite una probabilidad estacionaria única. Basta resolver el siguiente sistema de ecuaciones:

Esto da el vector (4/25, 12/25, 9/25).

Ejercicio 2

Como en el ejercicio 1 con la siguiente matriz estocástica:

0 | 0.5 | 0.5 | 0 |

0 | 1 | 0 | 0 |

0 | 0 | 0 | 1 |

0 | 0 | 1 | 0 |

Notamos que 2 no se comunica con nadie, es un estado absorbente. Nadie se comunica con 1, el estado forma un clase de transición. Los estados 3 y 4 se comunican entre sí, forman una clase recurrente. Entonces hay tres clases {1}, {2}, {3,4}.

No hay garantía de probabilidad estacionaria. Resolvamos el siguiente sistema:

El sistema no permite una sola solución. Sea Pi2 entre 0 y 1, entonces encontramos una solución:

Observamos en la clase {3,4} que las probabilidades son iguales en una frecuencia de 2k, deducimos que la clase es periódica durante un período de 2. La clase {2} es absorbente, no hay período. La clase {1} es transitoria, por lo que no hay más población después de un tiempo k.

Ejercicio 3

Como en el ejercicio 1 con la siguiente matriz estocástica:

0 | 1 | 0 |

0 | 0 | 1 |

1 | 0 | 0 |

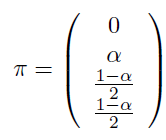

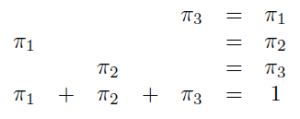

Ahora pasemos a la probabilidad estacionaria:

Lo que da el vector (1/3, 1/3, 1/3). En cuanto a la periodicidad, notamos que la matriz de transición se convierte en la matriz identidad cuando se eleva al cubo. Por lo tanto, podemos deducir que la cadena de Markov es periódica con periodicidad 3. Por lo tanto, la probabilidad estacionaria no existe; por otro lado, podemos concluir que en un gran paso aleatorio, pasamos 1/3 del tiempo en cada uno de los estados.

Ejercicio 4

A partir de los siguientes tres gráficos de transición, reconstruya las cadenas de Markov asociadas (espacio de estados y matriz). Luego haga el análisis de estas cadenas de Markov: las clases y características, ley estacionaria, probabilidad de absorción, tiempos medios de absorción).

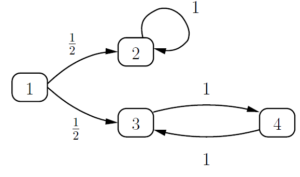

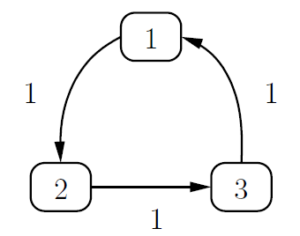

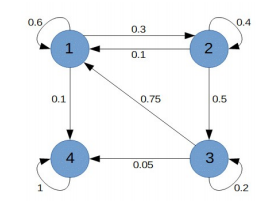

PRIMERO CUADRO :

Todos los estados se comunican, por lo que solo hay una clase necesariamente recurrente. Tenga en cuenta que la matriz de potencia 4 da la matriz de identidad, la periodicidad es por lo tanto 4.

Ahora calculemos la distribución estacionaria:

Dado que hay periodicidad, sabemos que no hay convergencia. Además, un paso aleatorio pasará ¼ de su tiempo en cada estado. En cuanto a la absorción, tenemos una cadena irreducible, por lo que la probabilidad de estar en la clase única es 1.

SEGUNDO GRÁFICO:

Todos los estados se comunican, los estados son todos del mismo período. La matriz parece similar al primer gráfico, pero tenga en cuenta que el estado 1 tiene un bucle, por lo tanto del período 1. La clase única es por lo tanto aperiódica (del período 1).

Como la cadena es aperiódica e irreductible, sabemos que converge hacia la distribución estacionaria.

Como solo hay una clase, el cálculo de las probabilidades de absorción es simple, desde cualquier estado, siempre vamos en la misma clase.

TERCER GRÁFICO:

Tenemos cuatro clases

{1} que es transitorio, por lo tanto, no hay periodicidad.

[2} que es recurrente con un bucle, por lo tanto, una periodicidad de 1.

{3} igual que {1}

{4} igual que {2}

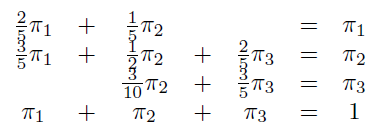

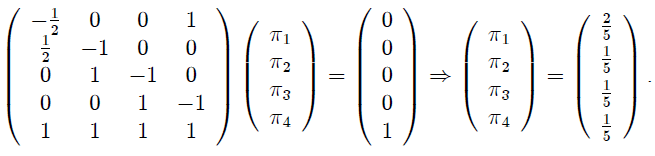

Calculemos la distribución estacionaria. Dado que existen clases transitorias, sabemos que no habrá convergencia:

Tenga en cuenta que hay un número infinito de soluciones.

Calculemos las probabilidades de absorción. Comencemos con el estado 2. Calculemos el vector v tal que vI es igual a la probabilidad de que la cadena sea absorbida en 2 sabiendo que comienza en i. Los cálculos son simples ya que tenemos dos clases transitorias de expectativa 1 (sin bucle y de estado único).

Por tanto sabemos que el estado 2 se alcanza con un paso de 1 como máximo, esto reduce considerablemente el número de cálculos. En efecto, la probabilidad de llegar a 2 partiendo de 1 se conoce ya que es p12. Por lo tanto, las probabilidades de transición son la segunda columna de P. De manera similar, las probabilidades de absorción del estado 4 son la cuarta columna de P. En el caso general, es necesario calcular el vector v tal que (PI) v = 0.

Podemos calcular el tiempo medio de absorción. Los estados 2 y 4 son recurrentes por lo tanto x2= x4= 0. Es rápido ver que x1= x3=1+0=1.

Ejercicio 5

Considere el siguiente ejemplo:

Calcule la probabilidad de las siguientes trayectorias (h, a, f, h), (h, a, f, a), (a, a, a).

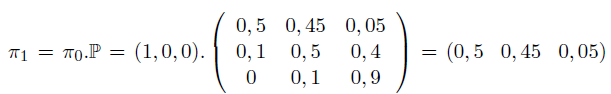

Calcule la distribución de los estados X1 en el tiempo t = 1 si asumimos que X0 = (1, 0, 0).

Interpretar.

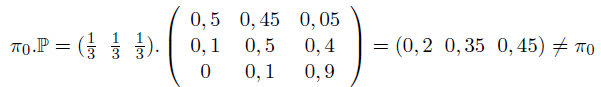

Muestre que una distribución uniforme X0 = (1/3, 1/3, 1/3) no es una distribución estacionaria para esta cadena de Markov.

¿Existe una distribución estacionaria para esta cadena de Markov?

P (h, a, f, h) = X0 (h) * 0.45 * 0.4 * 0 = 0

P (h, a, f, a) = 0.018 * X0 (h)

P (a, a, a) = 0.25 * X0 (a)

Entonces, después de tres iteraciones, la mitad de la parcela está cubierta con pasto, .45 arbustos y .05 con bosque, asumiendo que al principio solo hay pasto.

La distribución uniforme no es estacionaria. Para calcular la distribución estacionaria es necesario resolver el sistema XP = X:

Lo que da la solución (2/53, 10/53, 41/53). Podemos concluir que tendemos hacia una mayoría de bosque, con una densidad de 41/53.

Ejercicio 6

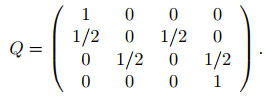

Consideramos una cadena de Markov de cuatro estados según la siguiente matriz de transición:

Determine las clases de la cadena y luego la probabilidad de absorción del estado 4 a partir de 2.

Determine el tiempo de absorción en 1 o 4 a partir de 2.

Notamos que el estado 1 y el estado 4 son ambos estados absorbentes, formando dos clases. Los estados 2 y 3 se comunican pero pueden ir en una clase absorbente. Deducimos que {2,3} forma una clase transitoria.

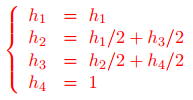

Según el curso, la probabilidad de absorción de un estado absorbente k de un estado i se resuelve mediante el siguiente sistema:

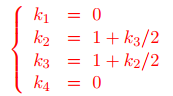

Esto da el siguiente sistema:

Y entonces el vector solución (0; 1/3; 2/3; 1), h1= 0 para no influir en las otras ecuaciones. Deducimos por h2 la probabilidad de absorción del estado 4 a partir de 2.

Según el curso, el tiempo de absorción por un estado absorbente k de un estado i se resuelve mediante el siguiente sistema:

Esto da el siguiente sistema:

Y entonces el vector solución es (0; 2; 2; 0). El tiempo de absorción K2 dar la respuesta correcta.

Ejercicio 7

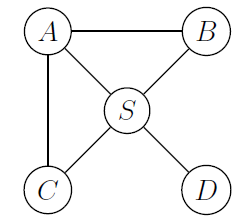

Consideramos una red de carreteras compuesta por 5 ciudades A, B, C, D, S de la siguiente manera:

Para modelar el tráfico rodado, consideramos que los automóviles toman una vía que sale de la ciudad de manera equitativa (uniforme). Denotar por Xno la variable aleatoria que representa la ciudad a la que llegó un automóvil en el momento n.

- Justifique que el proceso probabilístico es de hecho estocástico y forma una cadena de Markov. Y da la matriz de transición.

- ¿Cuál es la probabilidad de que, a partir de B, el automóvil esté en C después de dos iteraciones?

- Clasifique los estados en clases y calcule sus períodos.

- Escribe el sistema de ecuaciones verificado por probabilidades estacionarias.

- Denotamos el número de rutas que resultan de i. Deducir una distribución de una población inicial en función de. Calcula la distribución estacionaria. ¿Es ella única?

- Se observa un automóvil durante un tiempo N que se supone que es muy grande. Aproximadamente, ¿cuánto tiempo ha pasado en un estado determinado?

- A partir de S, ¿cuál es la cantidad promedio de pasos que necesita el automóvil para volver a S?

- ¿Cuál es la probabilidad de que, a partir de S, el automóvil visite la ciudad D antes que la ciudad C?

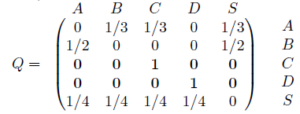

- Incluso conociendo toda su trayectoria pasada, el destino del automóvil solo se decide desde su posición actual. Además, según la definición del ejercicio, el coche tiene una probabilidad de 1 de salir de su ciudad actual, y por tanto de dar un paso hacia ciudades conectadas. La elección del paso es independiente del pasado, de hecho estamos en presencia de una cadena de Markov. La matriz de transición es la siguiente:

- Solo hay dos caminos que van de B a C en dos pasos: BAC y BSC. La probabilidad de pasar de B a C en dos pasos es, por tanto, igual a ½ * 1/3 +1/2 * ¼ = 7/24.

- Como muestra el gráfico, todos los estados están vinculados entre sí, todos se comunican y, por lo tanto, solo forman una única clase recurrente (por lo tanto positiva). La cadena es irreductible. En cuanto a la periodicidad, tenga en cuenta que hay cadenas de todas las longitudes de A a A. La cadena es por tanto aperiódica.

- Ver el curso.

- Tenga en cuenta que el vector de distribución calculado por el número de salidas de cada ciudad corresponde al vector de probabilidades estacionarias (1/4, 1/6, 1/6, 1/12, 1/3). Esta probabilidad es única ya que la cadena es ergódica.

- Como la cadena es ergódica, sabemos que su comportamiento asintótico es equivalente a las probabilidades estacionarias. Por ejemplo, el automóvil pasará 1/12 de su tiempo en el estado D.

- Una vez más, la cadena es ergódica, sabemos que la expectativa es la inversa de la probabilidad estacionaria. Por tanto, el tiempo medio para volver a S es de 3 pasos.

- Este punto es mucho más complejo de deducir. La idea es hacer que la cadena de Markov sea absorbente en C o D. La probabilidad, a partir de S, de llegar a D es, por tanto, la probabilidad de ser absorbido por la clase {D}. Primero, modificamos los estados C y D de la siguiente manera:

Luego tenemos dos clases recurrentes (y absorbentes) y una clase de transición que contiene {A, B, S}. Solo queda calcular las probabilidades de absorción y concluir (ver el curso).

Ejercicio 8

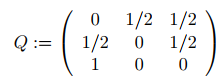

Consideramos una cadena de Markov con tres estados con la siguiente matriz de transición:

¿Cuáles son los estados recurrentes, transitorios y de estado estacionario? Calcula el tiempo para llegar a cada estado. Calcula el período de cada estado. Deducir sobre la distribución estacionaria.

Del estado 1 podemos pasar al estado 2 y 3, del estado 2 podemos pasar al estado 1 y 3, del estado 3 podemos pasar al 1 y por transitividad del 1 al 2 deducimos que el 3 puede ir al 2. Todos los los estados se comunican por tanto la cadena es irreductible, todos los estados son positivos recurrentes.

Por lo tanto, la cadena admite una ley de valor estacionaria única (4/9; 2/9; 3/9)

El tiempo de alcance en un estado es el inverso de los valores de la ley estacionaria.

Cuando calculamos Q² y Q3, notamos que el valor en el índice (1,1) es positivo, por lo que no hay período. No es útil verificar toda la diagonal porque hemos demostrado que todos los estados son parte de la misma clase.

La cadena es ergódica, su carácter asintótico tiende hacia la distribución estacionaria.

Ejercicio 9

Para representar el paso de una molécula de fósforo en un ecosistema, consideraremos cuatro estados posibles:

- la molécula está en el suelo,

- la molécula está en la hierba,

- la molécula fue absorbida por el ganado,

- la molécula ha abandonado el ecosistema.

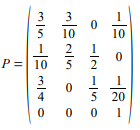

La matriz de transición es la siguiente:

Representa la cadena de Markov asociada. Estudia la cadena de Markov.

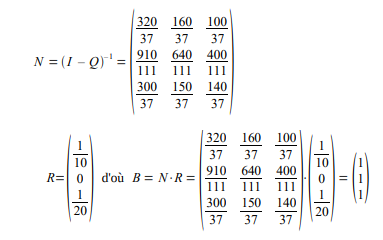

Pi = (0, 0, 0, 1) debido al estado absorbente. Es posible calcular N y B mediante: